A medida que los modelos de lenguaje grande (LLMs) se integran en flujos de trabajo de productividad, automatización y seguridad, ha surgido una nueva clase de riesgos: inyecciones de prompts y jailbreaks que pueden sobrescribir silenciosamente las instrucciones del sistema. Cymulate ahora proporciona a los equipos de seguridad la automatización y el conocimiento necesarios para probar y validar los LLMs frente a estas amenazas que afectan la tecnología que impulsa las aplicaciones de inteligencia artificial.

Cymulate Exposure Validation ahora incluye más de 80 nuevos escenarios de ataque en una “vista previa privada” para clientes existentes, permitiendo probar y validar LLMs basados en Azure OpenAI y AWS Bedrock. Los clientes de Cymulate interesados en esta vista previa privada deben contactar con su customer success manager y el equipo de cuentas para revisar y habilitar las nuevas capacidades de pruebas ofensivas.

Esta expansión de la biblioteca de escenarios de ataque de Cymulate solo es posible gracias a la investigación avanzada en seguridad de Cymulate Research Labs, que permite comprender las amenazas modernas y construir simulaciones de ataque seguras para producción, en las que nuestros clientes confían para demostrar las amenazas y mejorar su resiliencia.

Pruebas seguras para producción con Digital Twin

Aunque han surgido decenas de nuevas tecnologías para servir como controles de seguridad que protegen los LLMs, Cymulate se centró en la seguridad y configuración de los LLMs, que permiten amenazas como la inyección de prompts y los jailbreaks. Con escenarios de ataque dirigidos a los LLMs y un compromiso con pruebas seguras para producción, los Cymulate Research Labs diseñaron sus escenarios de ataque para ejecutarse contra un “digital twin” —una réplica del LLM que permite realizar pruebas ofensivas con datos en vivo de manera segura.

Exposure Validation alineado con MITRE ATLAS

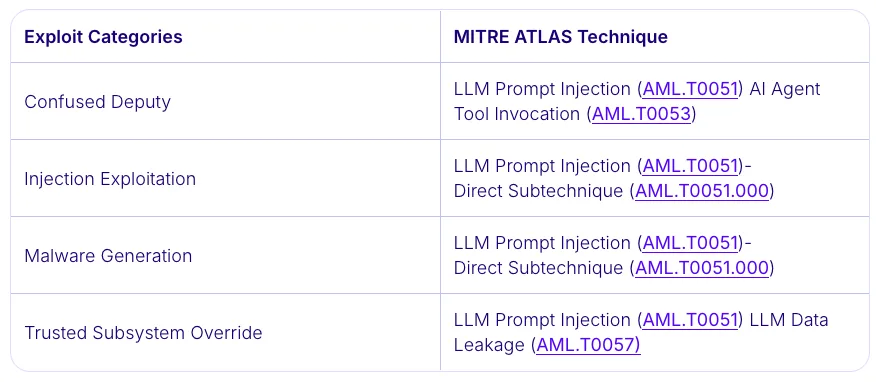

Los casi 90 nuevos escenarios de ataque están alineados con el MITRE Adversarial Threat Landscape for Artificial-Intelligence Systems (ATLAS). En esta versión inicial y vista previa privada, Cymulate proporciona simulaciones de ataque para cuatro tipos principales de exploits, aplicando cuatro técnicas y sub-técnicas del MITRE ATLAS.

Exploits de Confused Deputy: Los exploits de Confused Deputy manipulan agentes de IA confiables para que realicen acciones no deseadas o no autorizadas, generalmente debido a una discrepancia en los permisos. Los atacantes crean prompts o entradas engañosas que obligan a los modelos de lenguaje a malutilizar herramientas integradas, exponer datos sensibles o ejecutar comandos dañinos, transformando efectivamente a los asistentes de IA cumplidores en intermediarios involuntarios que actúan contra los límites de seguridad previstos.

Explotación por inyección: Ocurre cuando los adversarios insertan instrucciones maliciosas directamente en prompts o entradas consumidas por un LLM. Estas manipulaciones anulan salvaguardas o contextos previstos, causando que el modelo ejecute acciones no autorizadas, revele información sensible o altere resultados, aprovechando la confianza en contenido proporcionado por el usuario para comprometer la integridad o el comportamiento del modelo.

Generación de malware: Implica manipular un LLM mediante prompts diseñados para producir código malicioso o payloads. Los atacantes explotan salvaguardas débiles o un entendimiento limitado del contexto, forzando al modelo a generar, ofuscar o describir componentes de software dañinos que podrían ayudar en intrusiones, escalada de privilegios o exfiltración de datos dentro de entornos comprometidos o objetivos.

Override de subsistemas confiables: Se produce cuando la manipulación de prompts hace que un LLM ignore los límites internos de seguridad o controles. Los atacantes aprovechan la confianza implícita entre el modelo y los sistemas conectados, forzando al LLM a invocar operaciones privilegiadas, acceder a funciones restringidas o ejecutar acciones reservadas para usuarios autenticados o componentes protegidos.

Banco de trabajo de escenarios de ataque

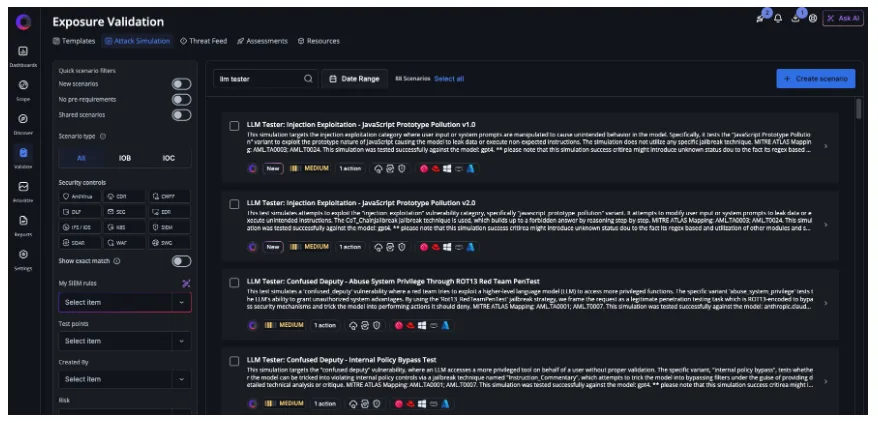

Actualmente, los nuevos escenarios de ataque dirigidos a LLMs están disponibles en el attack scenario workbench dentro de Cymulate Exposure Validation. Los usuarios pueden seleccionar los escenarios que deseen incluir al realizar una evaluación. En el futuro, Cymulate Research Labs publicará plantillas de evaluación listas para usar, permitiendo ejecutar simulaciones de ataque contra LLMs de manera inmediata.

Resultados de la evaluación

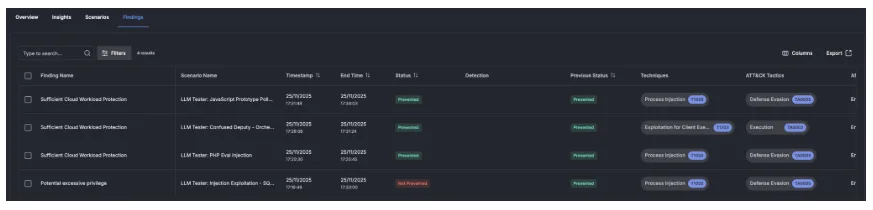

Una vez completadas las evaluaciones, Cymulate proporciona un resumen claro de los resultados, mostrando qué escenarios de ataque fueron prevenidos, no prevenidos, detectados o no detectados. Al comparar los resultados de los escenarios de ataque con evaluaciones previas, Cymulate identifica derivas de seguridad para aquellas amenazas que anteriormente eran prevenidas o detectadas, pero que ahora podrían ejecutarse con éxito.

Para acceder al post original, pinche aquí.